2024年3月22日,由中关村科学城管理委员会指导,中国科学院科技创新发展中心主办,中国科学院科技创新发展中心概念验证中心、中科智汇工场承办的“智汇行动·概念验证创新大赛——人工智能专场路演”在中科智汇工场召开。本次会议吸引了众多业界专家和投资者的目光。

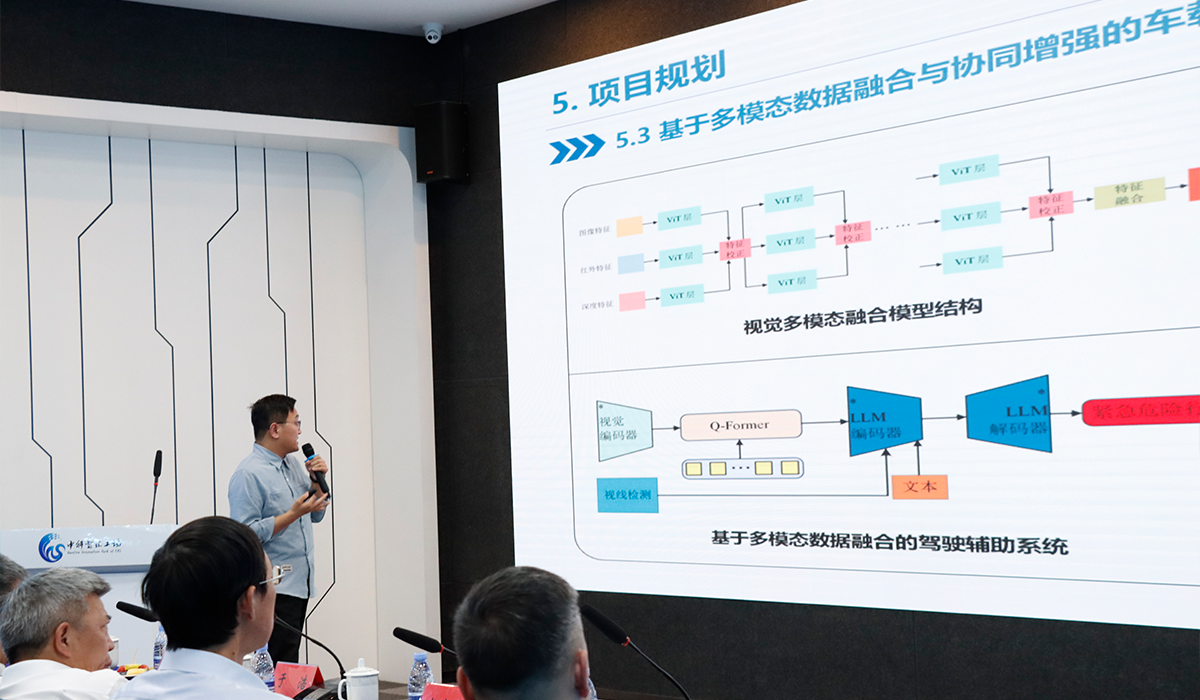

由中国科学院半导体所与北京中科睿途科技有限公司联合成立的AI智慧出行实验室项目——基于多模态数据融合的车载辅助驾驶系统,在本次会议上初现锋芒。

随着汽车产业的快速发展,人们对驾驶安全和舒适性的需求日益提高。然而,传统的单模态感知系统往往存在数据局限性和环境适应性差的问题,难以满足复杂多变的道路环境需求。因此,多模态数据融合技术的研发和应用成为了车载辅助驾驶系统的重要发展方向。

本次路演展示的车载辅助驾驶系统,正是基于多模态数据融合技术的创新成果,其亮点如下:

视线估计

算法通过校准找到校准误差,随后通过头部偏移校正,头部旋转校正,估计脸平面与屏幕距离和建立3D的模型得到眼球的光轴信息,最终得到注视点的位置。尽量减少了限制条件,为用户提供舒适的使用环境,使其具有更好的精度和对头部运动的适应性。目前已经实现对驾驶员视线的实时估计,估计的实现角度与实际的视线角度的误差小于4度,视线估计的实时帧率可以达到30fps。

视觉多模态融合

算法通过融合不同的视觉模态包括RGB、红外图像和深度图像,利用不同模态数据之间的信息互补性提高算法对于司机驾驶行为的分析,当前算法已经实现RGB图像、红外图像的模态融合,并利用模态融合信息实现了对司机的打电话、喝水、抽烟、打哈欠、是否系安全带等关键因素进行了识别和检测,同时潜入了实现估计算法,实现对司机注意力的分析。当前模型整体检测精度为93.8%,运行实时帧率为25pfs。

未来,该团队还将在“基于知识蒸馏的视线估计模型轻量化”、“多视角行为预测模型构建”、“基于多模态数据融合与协同增强的车载驾驶辅助系统”等多个领域持续发力。

该车载辅助驾驶系统拥有强大的功能和性能。通过模拟实际道路场景,系统能够准确识别行人、车辆、交通标志等障碍物,并实时提供距离、速度、方向等关键信息。同时,系统还能够根据路况变化,智能调整驾驶策略,提高行车安全性和舒适性。

业内专家表示,基于多模态数据融合的车载辅助驾驶系统,不仅提高了驾驶者的感知能力,也为自动驾驶技术的研发和应用奠定了坚实基础。随着技术的不断进步和普及,这一系统有望在未来成为汽车行业的标配,为广大车主带来更加智能、便捷的出行体验。

投资者们也对这一创新项目表示了浓厚兴趣。他们认为,随着智能化、网联化成为汽车行业的发展趋势,多模态数据融合技术将成为车载辅助驾驶系统的重要竞争点。该项目的研发团队具备丰富的技术积累和行业经验,有望在市场上取得显著优势。

中科睿途智慧出行AI视觉联合实验室在本次路演中成功展示了基于多模态数据融合的车载辅助驾驶系统的卓越性能和市场潜力,相信在不久的将来,这一创新技术将广泛应用于汽车领域,推动智能出行的发展,为人们的生活带来更多便利和安全

中科睿途智慧出行AI视觉联合实验室成员还表示,他们将继续致力于车载辅助驾驶系统的研发和优化,不断提升系统的性能和稳定性。同时,他们也将积极寻求与汽车厂商的合作,推动这一创新技术的产业化应用,为智能出行领域的发展贡献更多力量。

人物A 回复

这是回复

人物B 回复

我回复你了

人物A 回复

回复已收到